관련종목▶

[파이낸셜뉴스] 올해는 생성형 인공지능(AI) 활용 원년이 될 것으로 예상되는 가운데 AI 신뢰 및 안정성 문제가 화두로 떠오르고 있다. 생성형 AI가 예상치 못한 결과물을 도출해낼 경우 AI 모델 개발사 이미지에도 큰 타격을 입힐 수 있기 때문에 기업들은 자체적으로 내부 점검 팀을 꾸리는 등 기능 개선에 나서고 있다.

2월 29일 업계에 따르면 구글은 현재 자사 AI 모델 제미나이(Gemini)의 이미지 생성 기능을 일시 중단한 상태다. 제미나이는 텍스트와 이미지, 음성, 영상을 생성하는 멀티모달 기반의 AI 모델로, 구글은 이달 1일 이미지 생성 기능을 추가한다고 발표한 지 20일 만에 해당 서비스를 중단했다.

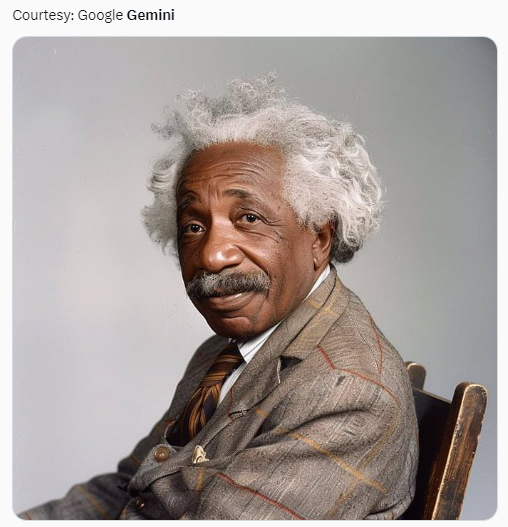

제미나이의 이미지 생성 서비스 공개 이후 사회관계망서비스(SNS)에는 제미나이가 아인슈타인 등 역사적 인물을 유색인종으로 잘못 생성하고 있다는 지적이 제기됐다. 더버지 등 외신에 따르면 서비스 중단 후 순다르 피차이 구글 최고경영자(CEO)도 28일(현지시간) 직원들에게 이메일을 통해 이미지 생성 기능 오류에 대해 "문제가 있다. 이용자들에게 불쾌감을 주고 편견을 드러냈다"며 "전혀 용납할 수 없는 일이고, 우리(구글)가 잘못한 것"이라고 시인하기도 했다.

이처럼 생성형 AI가 급속도로 발전함과 동시에 다양한 오류도 나타나며 글로벌 기업들은 AI 신뢰 및 안정성 확보에 집중하고 있다.

마이크로소프트(MS), 구글 등은 AI 레드팀(테스터) 등을 운영하고 있다. 레드팀은 LLM 모델의 취약점을 찾을 뿐 아니라 AI에 대한 신뢰성와 안정성을 확보하는 역할을 한다. 오픈AI도 최근 텍스트를 동영상으로 만들어주는 AI 시스템 소라를 공개하며 영화 제작사, 비주얼 아티스트, 디자이너 등 일부가 합류한 '레드팀'과 함께 안전성 테스트를 거치고 있다고 밝힌 바 있다.

국내 기업들도 생성형 AI의 윤리성에 대해 내부적으로 지속 점검 중이다.

지난해 8월 초대규모 AI '하이퍼클로바X'를 발표한 네이버는 올해 초 AI 안전성 연구를 전담하는 조직 ‘퓨처 AI 센터’를 신설했다. 센터에서는 AI 안전성을 높이기 위한 기술을 연구하고 AI윤리 정책을 수립할 예정이다. 카카오도 지난해 3월 ‘카카오 공동체의 책임있는 AI를 위한 가이드라인'을 새로 제정했다. '카카오 공동체 기술윤리 보고서'에 따르면 카카오의 AI 연구 전문 계열사 카카오브레인은 이미지 생성 모델인 칼로와 LLM인 코GPT2.0 관련 서비스에 대해 모델 학습에 클렌징된 데이터를 사용하고 프롬프트(명령어) 금칙어 필터링, 출력물 자동·육안 확인 등의 내용을 방침으로 하고 있다.

카카오뱅크 등 주요 계열사에서도 자체적으로 AI 윤리 원칙을 수립하고 있다. 정보기술(IT) 업계 관계자는 "AI가 학습하는 정보를 수집하는 단계부터 결과물이 나오는 시점까지 개발사들은 신경 쓸 내용이 많다"며 "AI 개발 및 테스트 시 너무 조심스럽게 접근하는 게 아니냐는 내부 평가도 나오지만, 생성형 AI는 현재 사회적 관심이 큰 사안인 만큼 당연한 조치로 봐야 한다"고 평가했다.

soup@fnnews.com 임수빈 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지