관련종목▶

6개월 만에 업그레이드된 'GPT-4o' 선보여

GPT-4o 사용자와 실시간 상호 교감이 특징

오픈AI 본격적인 AI 모델 수익화 시동 분석

【실리콘밸리=홍창기 특파원】 오픈AI가 최신 멀티모달(Multimodal·텍스트, 이미지, 오디오, 비디오) 거대언어모델(LLM)인 'GPT-4o'를 공개했다. 지난해 11월 GPT-4 터보 업그레이드 후 6개월만이다. 오픈AI가 구글의 연례개발자회의(I/O) 개최 하루 전에 업그레드이된 GPT-4o를 내놓은 것은 AI 선구자 구글 보다 오픈AI가 AI 기술에서 앞섰다는 선언을 한 것으로 풀이된다. 동시에 오픈AI는 GPT-4o를 통해 본격적인 수익 창출에도 나섰다는 진단이다.

실시간 통역하고 노래도 부른다

오픈AI는 13일(현지시간) 라이브 스트리밍을 통해 실시간 대화와 통역, 수학 문제 풀이 등 GPT-4o의 주요 기능을 보여줬다. GPT-4o의 'o'는 '옴니'를 뜻한다.

구글이 지난해 12월 최신 AI형 모델 '제미나이'를 소개할 때 미리 만들어진 조작된 영상을 보여줬다는 논란을 의식한 듯 오픈AI는 이날 GPT-4o의 주요 기능을 라이브 스트리밍으로 선보였다.

오픈AI는 이미 사용자의 음성에 응답하는 챗GPT '음성 모드'라는 기능을 제공하고 있다. GPT-4o는 기존의 음성 모드의 단점을 줄이고 장점을 추가했다. 텍스트와 이미지 및 오디오를 학습해 사용자의 목소리에 더 빠르고 정확하게 반응하는 것이다.

GPT-4o의 가장 큰 특징은 현재 출시된 타사의 음성 비서와 달리 사용자와 실시간으로 상호 작용한다는 점이다. 사용자의 요청에 따라 목소리 톤을 높이고 대화 속도를 빠르게 할 수 있다. 또 로봇 목소리 등 다양한 목소리로 말하고 노래도 부른다.

오픈AI는 GPT-4o가 사용자의 목소리 톤이나 얼굴 표정을 통해 사람의 감정도 감지할 수도 있다고 주장했다. 오픈AI의 미라 무라티 최고기술책임자(CTO)는 "GPT-4o는 사람들과 실시간으로 상호작용하며 대화한다"라고 강조했다.

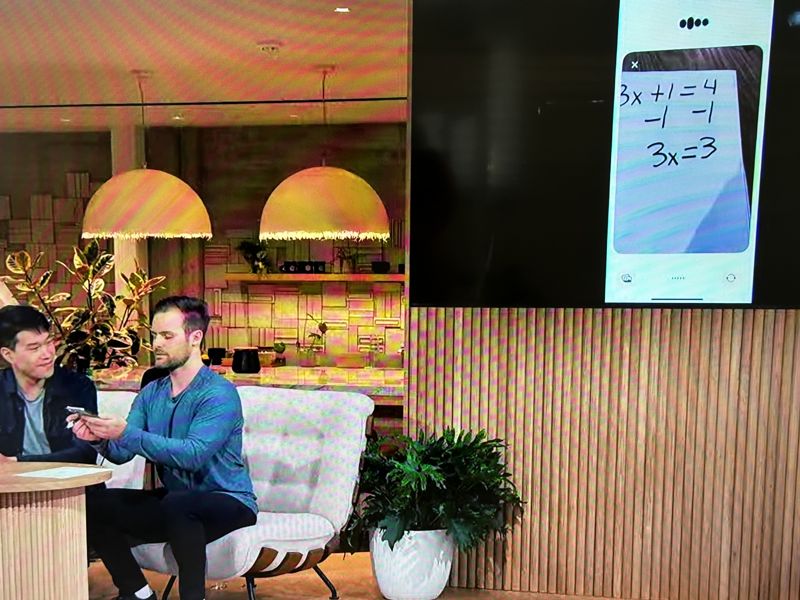

수학 과외 선생님 같은 GPT-4o

오픈AI는 이날 종이에 적힌 수학 문제를 'GPT-4o'가 인식해 사용자와 함께 풀어내는 장면도 실시간으로 시연했다. 또 다른 영상에서 GPT-4o는 수학 문제 정답을 바로 말하지 않고 이용자와 계속 대화하면서 답을 이끌어냈다.

무라티는 "GPT-4o는 텍스트 이외에 이미지와 동영상도 잘 분석할 수 있다"라고 말했다. 이와 관련, 오픈AI는 다른 영상을 통해 GPT-4o가 사용자가 입은 검은색 자켓을 설명하고 그의 방에 무엇이 있는지도 묘사하는 장면을 보여줬다.

샘 올트먼 오픈AI 최고경영자(CEO)는 GPT-4o를 영화에서 흔히 볼 수 있는 AI 도구에 비유했다.

올트먼 CEO은 "나와 다른 오픈AI 경영진이 음성 비서와 사랑에 빠진 한 남자의 이야기를 다룬 영화 'Her'(허)에서 영감을 얻었다"라고 말했다.

오픈AI는 몇 주 안에 GPT-4o를 월 20달러의 챗GPT-플러스를 결제하는 사용자에게 제공할 예정이다. GPT-4o는 기업에도 판매된다. 이와 관련, 무라티 CTO는 "GPT-4o는 현재 우리의 최고급 제품인 GPT-4 터보보다 두 배 빠르고 비용은 절반"이라고 설명했다.

월스트리트저널(WSJ)은 "오픈AI가 GPT-4o를 출시한 것은 오픈AI가 사용자 풀을 확장하고 AI를 통해 수익을 본격적으로 창출하기 위한 것"이라고 짚었다.

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지